引言

一直想找到一个简单又不需要太多魔法就能访问OpenAI较新模型的方法,目前看来Azure OpenAI + LobeChat基本满足我的需求了。

这个方案整体除了Azure OpenAI和LobeChat之外,还需要一台可以部署docker的服务器,最好跟Azure OpenAI在一个region,这样访问速度应该有保证。

部署Azure OpenAI

之前Azure OpenAI需要自己提交申请给Azure审核,通过之后才可用,现在不需要提交申请了,至少我的订阅不需要申请了,立刻部署起来试试。

首先在Azure portal找到Azure OpenAI,创建资源如下:

其中资源组名字和名称可以自定义,区域我选择的是JP east,因为我有一台服务器在这个region。

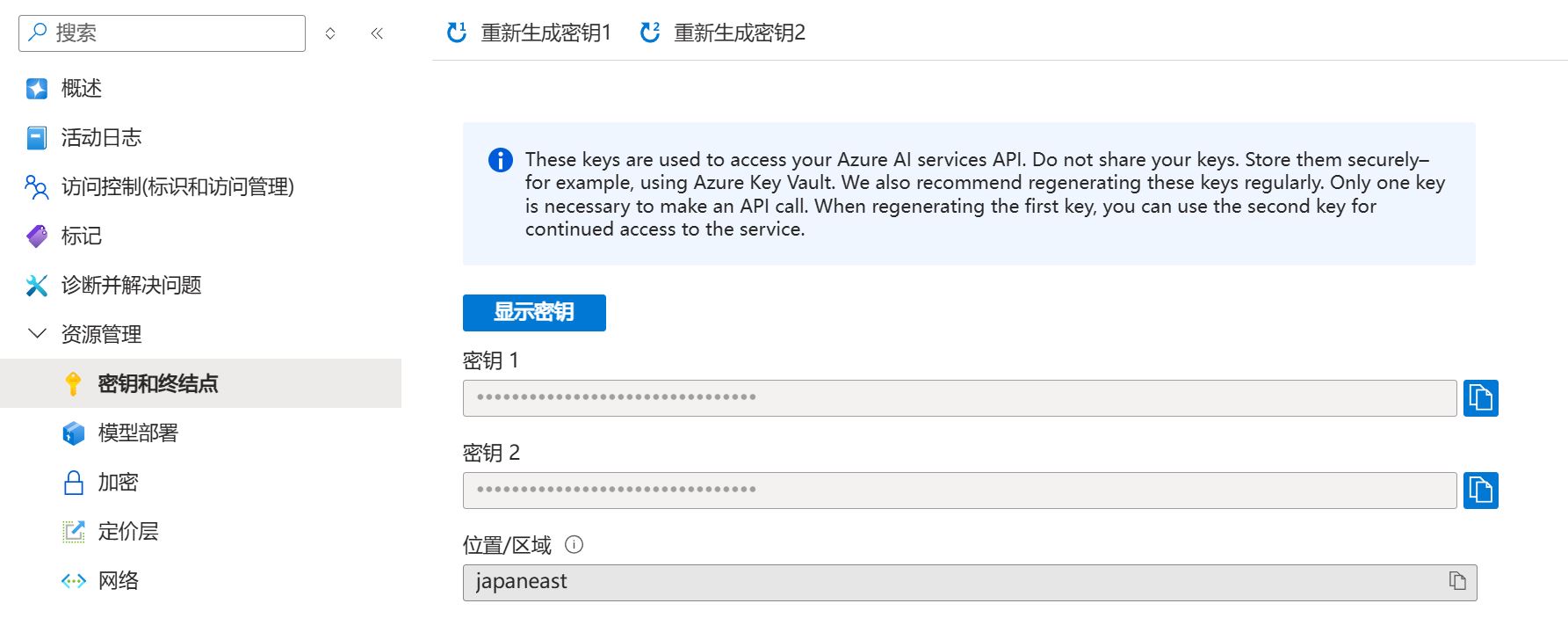

创建好后保存好密钥和终结点:

然后转到Azure OpenAI Studio,开始部署模型,这里选择的是gpt-4o:

gpt-4o-mini应该也是可用的。

部署LobeChat

LobeChat是开源的工具,可以通过它来访问多个厂家的大语言模型的API。安装方法简单,直接在JP east服务器上通过docker安装:

1

2

3

4

5

6

7

8

docker run -d -p 3210:3210 \

-e AZURE_API_KEY=<your_api_key> \

-e ACCESS_CODE=<website_password> \

-e AZURE_ENDPOINT=https://<endpoint>.openai.azure.com \

-e AZURE_API_VERSION=2024-02-15-preview \

-e USE_AZURE_OPENAI=1 \

-e OPENAI_MODEL_LIST=-all \

--name lobechat lobehub/lobe-chat

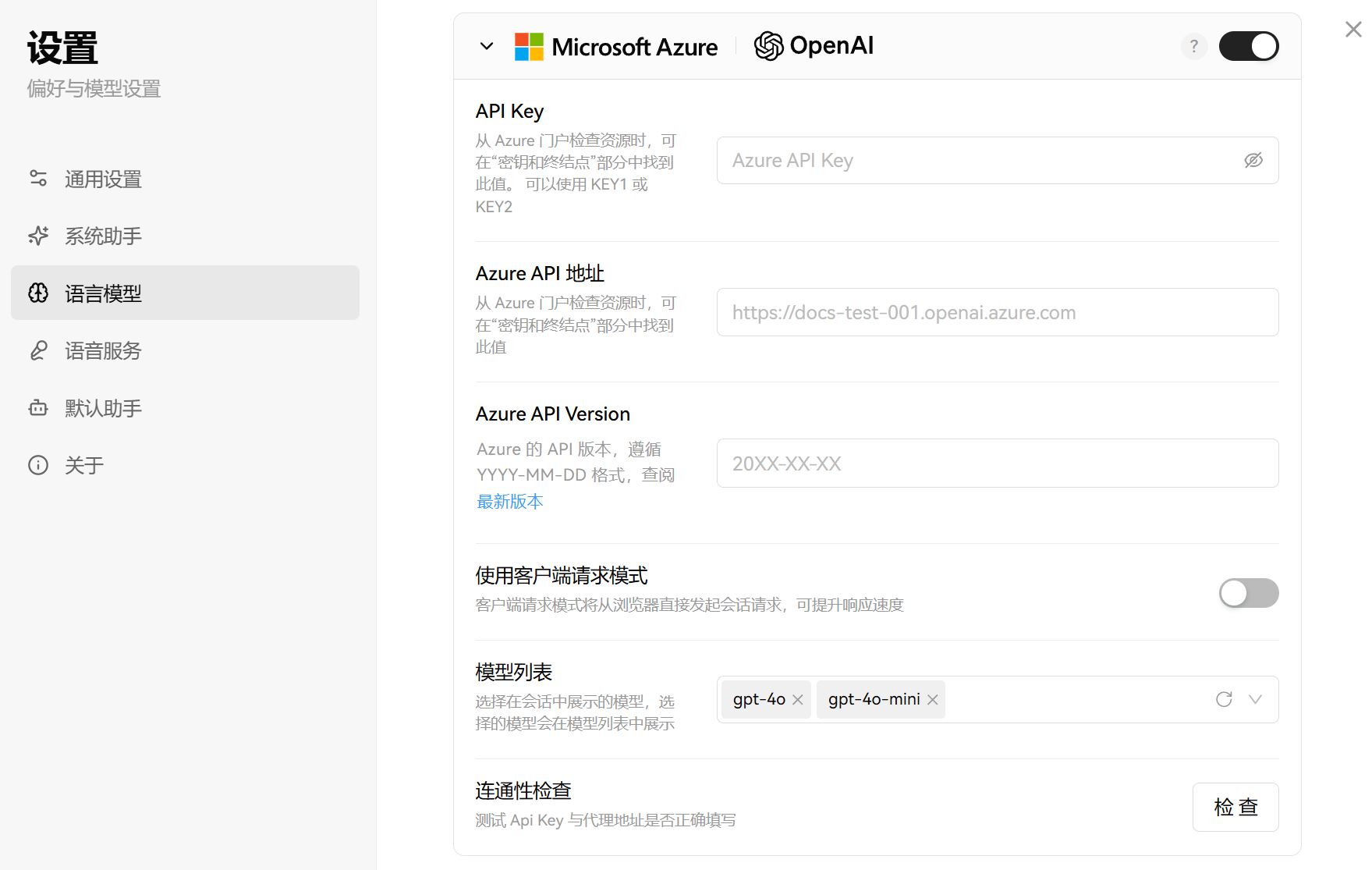

等docker起来之后,用浏览器访问服务器公网地址的3210端口,进入设置-语言模型:

在模型列表里新建gpt-4o并设置:

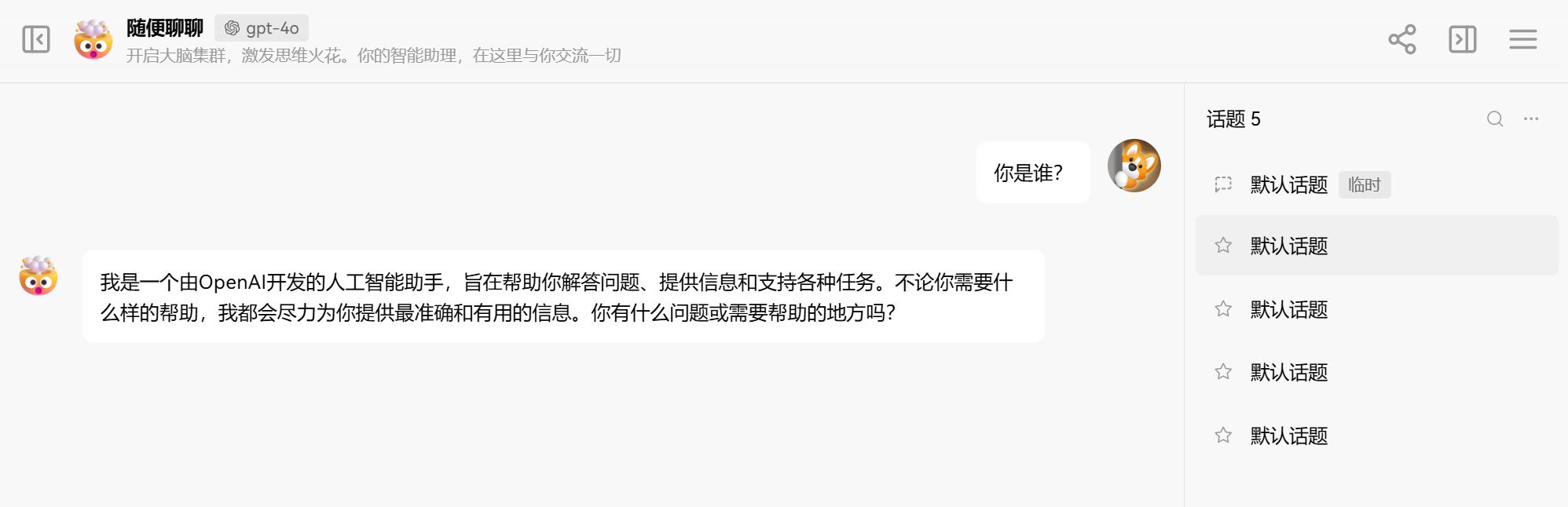

可以用连通性检查验证一下,之后就一切就绪,我们开始试试吧:

整体感觉体验还不错。

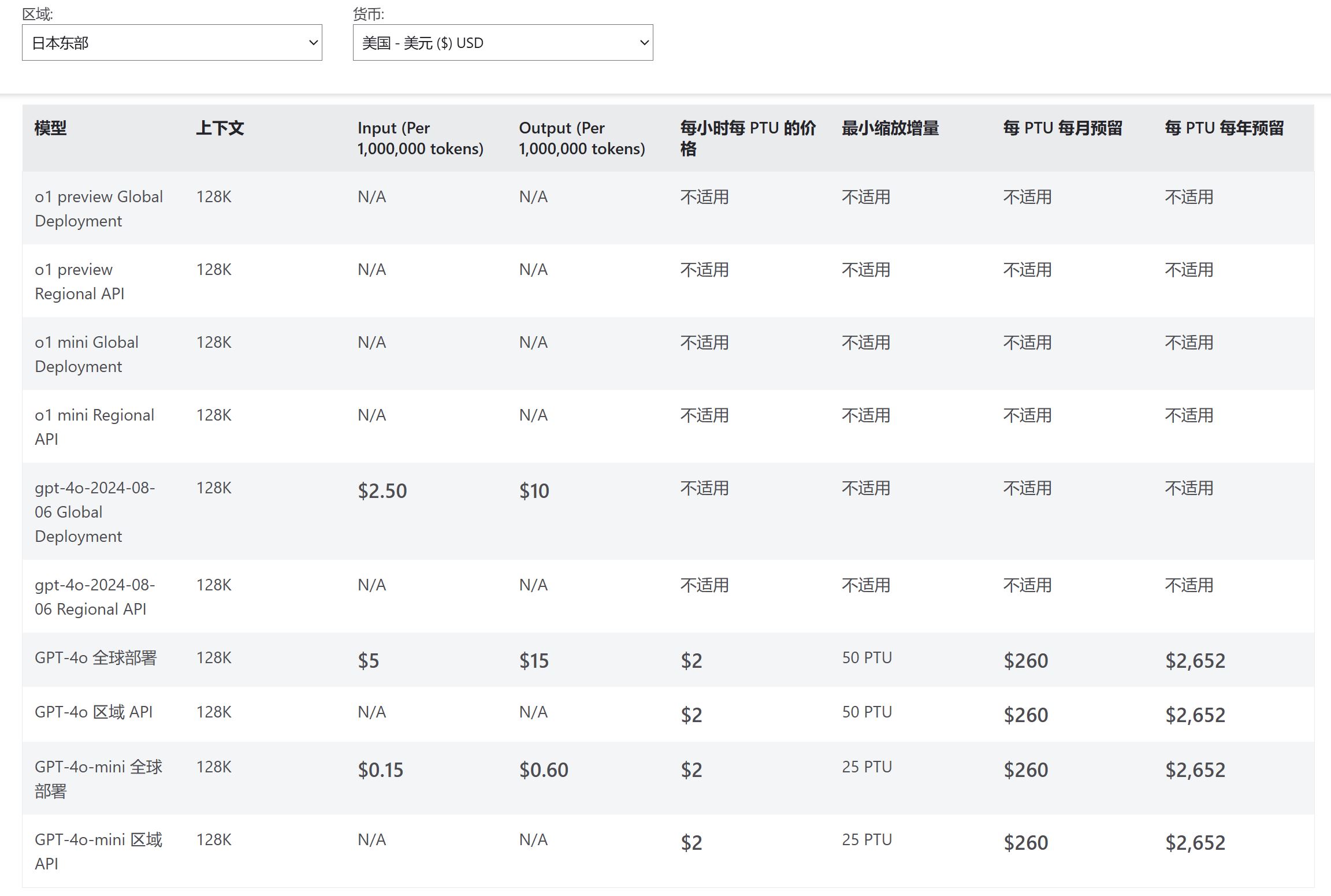

计费

Azure OpenAI同样基于token计费,具体请见:

比如刚刚部署的gpt-4o每百万个input tokens是5美元。